AI 프로젝트를 운영하다 보면, 이런 질문들이 반복해서 떠오릅니다.

“사용자마다 접근할 수 있는 메뉴를 구분할 수 있을까?”

“Hugging Face 없이도 폐쇄망에서 LLM을 배포할 수 있을까?”

“매번 환경을 새로 세팅하지 않고, 바로 실험을 시작할 수는 없을까?”

이번 Runway 업데이트는 이런 고민에서 출발했습니다. 실무에서 AI를 실제로 운영하다 보면, 단순히 모델을 개발하는 것을 넘어 권한 관리, 자원 배분, 폐쇄망 환경 같은 현실적인 과제들과 마주하게 되죠. Runway는 이러한 운영 과제를 해결하기 위해 만들어진 지속 가능한 AI 운영을 위한 엔터프라이즈 플랫폼입니다. 모델 학습과 배포, 자원 관리, 협업과 보안까지 기업이 AI를 일관되고 안정적으로 운영할 수 있도록 설계했습니다.

이번 릴리스에서는 특히, 조직 맞춤 권한 관리, 폐쇄망 LLM 서빙, 실험 환경 구성 등 실사용자에게 직접적인 가치를 주는 핵심 기능 3가지를 중심으로 Runway의 운영 효율성과 유연성을 한층 끌어올렸습니다. 이와 함께 실무에 도움이 되는 다양한 기능들도 함께 추가되었죠.

이제, 이번 업데이트를 통해 Runway가 어떻게 달라졌는지 자세히 살펴보겠습니다.

이번 업데이트에서 달라진 점

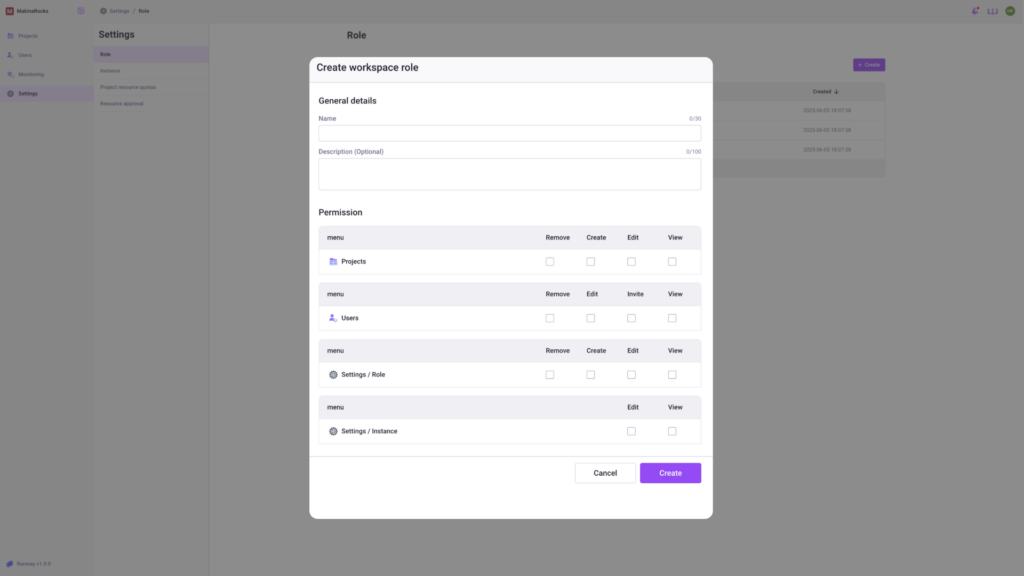

사용자 정의 역할 생성 및 메뉴별 권한 세분화

사용자 정의 역할 생성 및 메뉴별 권한 세분화 기능

사용자 정의 역할 생성 및 메뉴별 권한 세분화 기능

기존에는 Admin과 Member로 구분된 고정 역할만 제공되었지만, 이제는 조직의 정책과 목적에 맞게 메뉴 단위로 권한을 세분화하고, 역할을 직접 정의할 수 있습니다. 특정 유저에게 프로젝트 메뉴만 보여주거나, 세팅 접근을 제한하는 등 더 세밀하고 안전한 운영이 가능해졌습니다.

- 역할을 직접 정의해 사용자에게 부여

- 프로젝트, 사용자, 인스턴스 메뉴 등 세분화된 접근 제어

- 부서별·직무별 맞춤 권한 구성으로 협업 안정성 강화

오브젝트 스토리지 기반 LLM(.safetensors) 배포 지원

오브젝트 스토리지 기반 LLM 배포 지원 기능

이제 Hugging Face Hub 없이도, 자체 운영 중인 오브젝트 스토리지(S3, MinIO 등)에서 .safetensors 모델을 직접 불러와 추론 서비스로 배포할 수 있습니다. S3나 MinIO처럼 자체 운영 중인 저장소 경로만 입력하면, config.json, tokenizer.json과 함께 자동으로 인식되어 손쉽게 서빙할 수 있습니다.

- .safetensors 모델을 직접 업로드 및 서빙

- S3, MinIO 등 오브젝트 스토리지 경로만으로 배포 가능

- vLLM 등 최적의 런타임 자동 추천으로 운영 효율성 향상

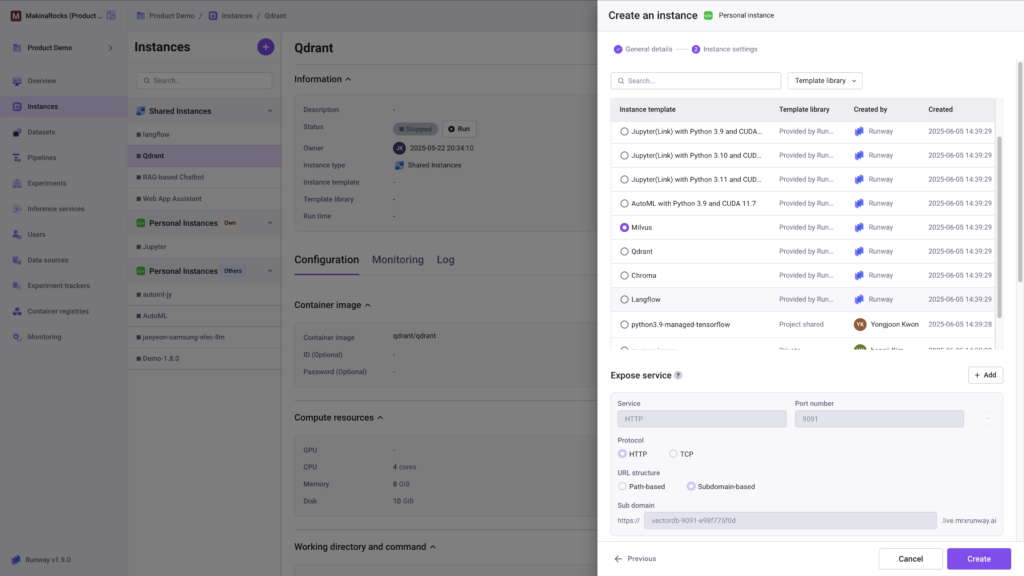

인스턴스 템플릿 및 실험 환경 구성

인스턴스 템플릿 및 실험 환경 구성 기능

인스턴스 템플릿 및 실험 환경 구성 기능

모델 실험을 위해 매번 환경을 새로 구성해야 했던 번거로움을 줄였습니다. 이제는 자주 사용하는 환경을 템플릿으로 저장하거나, 미리 구성된 대표 환경을 불러와 즉시 실행할 수 있습니다. Langflow, Milvus, Qdrant, Chroma 등 최신 GenAI 툴도 포함되어 있어, AI 개발과 실험을 빠르게 시작하고 팀원과 일관되게 공유할 수 있습니다.

- Langflow 등 최신 도구가 포함된 템플릿 기본 제공

- 사용자 정의 인스턴스 환경 저장 및 재사용 가능

- 실험 환경 구성 시간 대폭 단축

함께 추가된 기능들

프로젝트 결재 프로세스 도입

- 프로젝트 생성/변경 시 관리자 승인 요청 후 진행 가능, 승인 이력 관리 포함

프로젝트 자원 상한(Quota) 설정

- CPU, GPU, 메모리, 스토리지 등에 대한 프로젝트별 리소스 한도 지정 가능

프로젝트 공유 볼륨 (Shared Volume) 설정

- 프로젝트별 공유 볼륨 크기를 유연하게 설정하고, 운영 중에도 증설 가능

인스턴스별 자원 모니터링

- 실행 중인 각 인스턴스의 CPU, GPU, 메모리 등 자원 사용량을 실시간으로 확인

인스턴스 자원 회수 가능

- 불필요한 인스턴스를 관리자가 직접 종료 및 자원 회수 가능

새로운 기능을 직접 체험해 보세요

Runway의 최신 기능이 실제 AI 운영 환경에서 어떤 변화를 만드는지 직접 확인해 보세요. 지금 바로 데모를 신청하고, 지속 가능한 AI 운영의 새로운 기준을 경험해 보세요.